Zerosquare (./16212) :À nouveau, ce n'est pas une backdoor (même si c'est vachement plus sexy de parler de backdoor). Alors, oui, on peut imaginer des taupes chez Apple… mais dans ce cas, si c'était aussi simple, suffirait de placer directement la backdoor dans le code d'iOS.

Même en supposant qu'il y aura zéro demande abusive de la part de l'État (rire étouffé), ça ne fait que déplacer le problème : si une backdoor existe, alors la possibilité technique de faire ce que je disais précédemment existe

aussi, et un autre gouvernement moins honnête peut faire pression pour récupérer les données (ou carrément obtenir les clés). Ou placer des taupes chez Apple pour le faire de façon plus discrète. Ou, sachant qu'une backdoor existe, chercher des vulnérabilités dans son implémentation. Ou Apple peut se faire hacker. Ou changer un jour de politique, et se dire que c'est quand même bête d'avoir potentiellement accès à autant d'infos et de ne pas les exploiter commercialement. Ou...

Et le potentiel commercial d'un truc qui ne concerne qu'un pouillème des utilisateurs doit être très limité.

Si les dernières décennies en matière de sécurité info nous ont appris un truc, c'est bien qu'un seul moyen est concrètement efficace pour éviter que des données confidentielles ne soient exploitées de façon malveillante : qu'elles ne soient pas collectées au départ (ou mieux encore, pas collectables).Mais là, tu pars du principe que la sécurité individuelle prime par rapport à la sécurité collective.

C'est là que je ne suis pas d'accord : certes, il y a plein de choses qui existent en théorie. En pratique, ce n'est pas le cas.Zeph (./16210) :Comme je l'ai écrit dans mon message précédent, ils en ont déjà, et ça n'a rien de choquant en soi. La question est de savoir où on place la limite du "non, ça c'est trop".

- La police doit-elle avoir à sa disposition des moyens supplémentaires pour ne pas subir une trop forte pénalité par rapport à ce que peuvent faire les criminels ?

Brunni (./16211) :Ce n'est pas évident de dire ça, je trouve. Une backdoor qui se balade dans la nature est un vrai risque vu qu'elle peut être utilisée par n'importe qui. Là, on passe forcément par un système de réquisition passant par le département juridique d'Apple, comme toutes les réquisitions auprès d'entreprises.

Alors oui, sauf que la solution là a été d'enlever la sécurité complètement, ce qui est pire que d'avoir une backdoor (qui certes pourrait être exploitée par une organisation maléfique suffisamment puissante pour obtenir une zero-day qui passe inaperçue et dure dans le temps), non ?

Zeph (./16210) :Mais tu ne peux pas mener d'enquête sans violer la vie privée, c'est le principe même des enquêtes (à part peut-être quelques faits qui sont commis en public, ok). Le tout est d'avoir de la proportionnalité entre les atteintes à la vie privée et les faits reprochés (d'où les structures de contrôle mises en place en France).

- Est-ce problématique si ces moyens supplémentaires impliquent de pouvoir passer à travers les mécanismes assurant la vie privée des citoyens ?

Autant le premier point porte à discussion, autant j'ai du mal à croire qu'on puisse être de bonne foi en répondant un "non" pérementoire au deuxième, même avec une confiance aveugle dans les instances qui nous dirigent(que nous sommes par ailleurs visiblement plusieurs à ne pas partager)

Alors, oui, il faut des institutions fiables, mais ça c'est vrai d'une manière générale (et on aurait pas mal de travail si le voulait, clairement).

Et pour revenir au sujet :

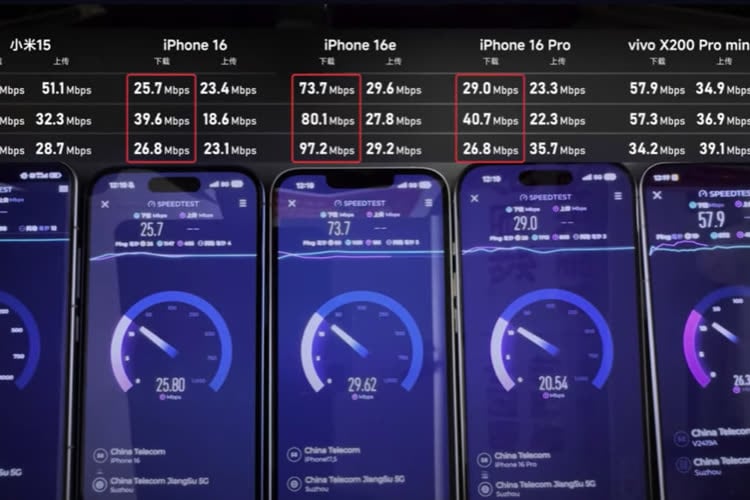

Le modem C1 d'Apple tient son rang face aux iPhone équipés en QualcommiGenerationLe modem C1 d'Apple utilisé pour la première fois avec l'iPhone 16e démarre sur de bonnes bases et tient parole en termes d'économie d'énergie.

Des tests effectués par Geekerwan (en chinois sous-titré anglais) montrent une certaine efficacité du C...

Apple fait une belle perf avec un premier modem 4G/5G qui est au niveau des meilleurs modèles actuels tout en consommant nettement moins, sachant que faire un modem a des défis d'autres natures qu'un processeur : probablement plus de brevets et surtout un besoin de compatibilité avec plein de réseaux d'opérateurs mal configurés.

Eutelsat teste la 5G non terrestre avec des satellites en orbite basseiGenerationEutelsat, Airbus et Mediatek viennent d'annoncer avoir réussi les premiers tests pour le déploiement d'un réseau 5G NTN (non terrestre) grâce aux satellites OneWeb d'Eutelsat, qui sont placés en orbite basse (1 200 km). Si la solution peut sembler pr...

Je suis surpris du choix de la bande millimétrique pour du satellitaire, alors que la portée est bien moindre

(que nous sommes par ailleurs visiblement plusieurs à ne pas partager)

(que nous sommes par ailleurs visiblement plusieurs à ne pas partager)